一.全文翻译

二.名词解释

1.hard negative mining method(难负例挖掘)

训练SVM时,由于训练数据太大,难以装进内存,RCNN采用hard negative mining method。

关于正例和负例:

假如给你一幅图,识别里面的人,人就是正训练样本,背景就是负训练样本。

复杂点说:对于目标检测, 我们会事先标记 ground truth,然后再算法中会生成一系列 proposal,这些 proposal有跟 ground truth重合的也有没重合的,那么 IoU 超过一定阈值(通常0.5)的则认定为是正样本,以下的则是负样本, 然后扔进网络中训练。

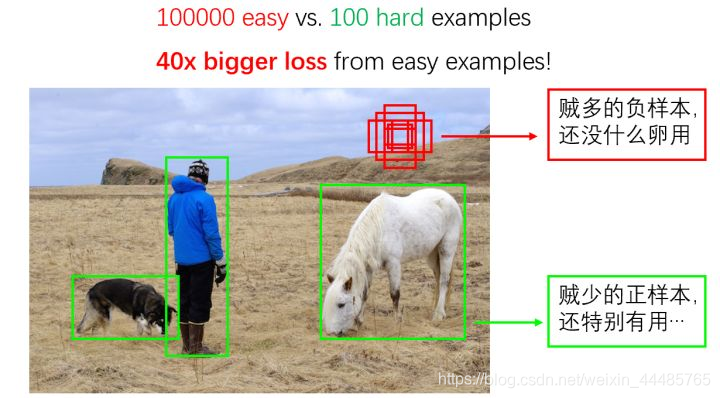

但经常会出现这样:easy example:通常为负例,hard example:正例+难负例

正样本的数量远远小于负样本,这样训练出来的分类器的效果总是有限的,会出现许多 false negative, 即预测为负例的正样本。

R-CNN中的难负例挖掘就是采用了自举法(bootstrap),不断地挑选hard nagtive,加入负例集,再次进行训练,重复以上操作,直到网络效果不能上升为止。

2.bbox=Bounding-box

bbox是每个region矩形框的位置信息。

RCNN中训练了一个线性回归模型在给定一个选择区域的pool5特征时去预测一个新的检测窗口。

三,语义分割

RCNN中与O2P(second-order pooling)做了对比。

第一个策略完全忽略区域的形状(full ignore),直接在变形后的窗口上计算CNN特征,就和我们检测时做的一样。但是,这些特征忽略了区域的非矩形形状。两个区域也许包含相似的约束框却几乎没有重叠。因此,第二个策略(fg,foreground)只计算前景遮罩(foreground mask)的CNN特征,我们将所有的背景像素替换成平均输入,这样减除平均值后他们就会变成0。第三个策略(full+fg),简单的并联全部(full)特征和前景(fg)特征;我们的实验验证了他们的互补性。

R-CNN 进行语义分割分为 3 个阶段。

1.利用 CPMC 生成候选区域,然后将这些区域调整大小为 227x227,送到神经网络当中,这是 full 阶段,区域中有背景也有前景。

2.这个阶段只处理候选区域的前景,将背景用输入的平均值代替,然后背景就变成了 0 ,这个阶段称为 fg。

3.full + fg 阶段,将背景和前景简单拼接。**

四,消融研究

RCNN发现CNN中的最后一层fc7的特征泛化能力不如fc6的特征。这意味29%的CNN参数,也就是1680万的参数可以移除掉,而且不影响mAP。更多的惊喜是即使同时移除fc6和fc7,仅仅使用pool5的特征,只使用CNN参数的6%也能有非常好的结果。

五,缺点

- 训练分为多个阶段,步骤繁琐: 微调网络+训练SVM+训练边框回归器

- 训练耗时,占用磁盘空间大:5000张图像产生几百G的特征文件

速度慢: 使用GPU, VGG16模型处理一张图像需要47s。

对图像提完Region Proposal(2000个左右)之后将每个Proposal当成一张图像进行后续处理(CNN提特征+SVM分类),实际上对一张图像进行了2000次提特征和分类的过程测试速度慢:每个候选区域需要运行整个前向CNN计算

SVM和回归是事后操作